Prérequis – Data Mining, la mesure de similarité fait référence à la distance avec des dimensions représentant les caractéristiques de l'objet de données, dans un ensemble de données. Si cette distance est inférieure, il y aura un degré élevé de similarité, mais lorsque la distance est grande, le degré de similarité sera faible. Certaines des mesures de similarité les plus populaires sont :

- Distance euclidienne.

- Distance de Manhattan.

- Similitude Jaccard.

- Distance Minkowski.

- Similitude cosinus.

Similitude cosinus est une métrique utile pour déterminer la similitude des objets de données, quelle que soit leur taille. Nous pouvons mesurer la similarité entre deux phrases en Python en utilisant la similarité cosinus. Dans la similarité cosinus, les objets de données d'un ensemble de données sont traités comme un vecteur. La formule pour trouver la similarité cosinus entre deux vecteurs est –

(x, y) = x . y / ||x|| ||y||>

où,

- X . y = produit (point) des vecteurs « x » et « y ».||x|| et ||et|| = longueur (grandeur) des deux vecteurs 'x' et 'y'.||x||

||et|| = produit régulier des deux vecteurs « x » et « y ».

||et|| = produit régulier des deux vecteurs « x » et « y ». Exemple : Prenons un exemple pour trouver la similitude entre deux vecteurs – 'X' et 'et' , en utilisant la similarité cosinus. Le vecteur « x » a des valeurs, X = { 3, 2, 0, 5 } Le vecteur « y » a des valeurs, y = { 1, 0, 0, 0 } La formule de calcul de la similarité cosinus est :  (x, y) = x. y / ||x||

(x, y) = x. y / ||x||  ||et||

||et||

x . y = 3*1 + 2*0 + 0*0 + 5*0 = 3 ||x|| = √ (3)^2 + (2)^2 + (0)^2 + (5)^2 = 6.16 ||y|| = √ (1)^2 + (0)^2 + (0)^2 + (0)^2 = 1 ∴ (x, y) = 3 / (6.16 * 1) = 0.49>

La dissemblance entre les deux vecteurs « x » et « y » est donnée par –

∴ (x, y) = 1 - (x, y) = 1 - 0.49 = 0.51>

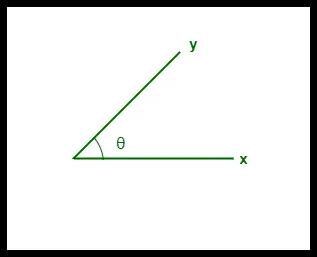

- La similarité cosinus entre deux vecteurs est mesurée en « θ ».

- Si θ = 0°, les vecteurs « x » et « y » se chevauchent, prouvant ainsi qu'ils sont similaires.

- Si θ = 90°, les vecteurs « x » et « y » sont différents.

Cosinus Similarité entre deux vecteurs

Avantages :

- La similarité cosinusoïdale est bénéfique car même si les deux objets de données similaires sont éloignés l'un de l'autre par la distance euclidienne en raison de leur taille, ils pourraient toujours avoir un angle plus petit entre eux. Plus l’angle est petit, plus la similarité est grande.

- Lorsqu'elle est tracée sur un espace multidimensionnel, la similarité cosinus capture l'orientation (l'angle) des objets de données et non la magnitude.